一、书籍介绍

1. 书籍名称与作者

- 书名:《从零开始大模型开发与微调》

- 作者:王晓华(高校计算机专业讲师,研究方向包括云计算、大数据与人工智能)

- 出版社:清华大学出版社

2. 书籍内容与目标读者

- 内容概述:

- 系统介绍基于 PyTorch 2.0 和 ChatGLM 的大模型开发与微调技术。

- 涵盖大模型的基本理论、算法、程序实现、应用实战及微调技术。

- 通过丰富的示例和实战案例,展示如何构建、训练、评估及微调大模型。

- 目标读者:

- PyTorch深度学习初学者

- 大型模型开发初学者及开发人员

- 希望掌握大模型开发与微调技术的人工智能爱好者

3. 书籍特色与优势

- 理论与实践结合:通过大量实战案例,帮助读者从理论走向实践。

- 技术前沿性:基于最新的 PyTorch 2.0 和 ChatGLM 技术栈。

- 全面覆盖:从基础开发到高级微调技术,一站式掌握大模型全流程。

二、大模型开发基础

1. 什么是大模型

- 大模型(Large Language Model, LLM)是一种基于深度学习技术的大规模神经网络模型,通过海量数据预训练,具备强大的语言理解和生成能力。

2. 大模型的应用场景

- 自然语言处理(NLP):文本生成、对话系统、机器翻译等。

- 计算机视觉(CV):图像分类、目标检测、图像生成等。

- 多模态任务:结合文本、图像、语音等多模态数据的任务。

3. 大模型开发流程

- 需求分析:明确应用场景和目标指标。

- 数据准备:数据收集、清洗和标注。

- 模型设计:选择模型架构,设计网络层数和参数。

- 训练与优化:配置训练环境,进行模型训练和优化。

- 评估与测试:验证模型性能,进行迭代优化。

- 部署与维护:将模型部署到生产环境,进行持续监控和维护。

三、大模型开发工具

1. PyTorch 2.0

- 简介:Facebook(现Meta)开发的深度学习框架,支持动态计算图和GPU加速。

- 优势:灵活、高效,适合大模型的开发和训练。

2. Hugging Face Transformers

- 简介:提供预训练模型和微调工具库,支持BERT、GPT等主流模型。

- 优势:简化模型加载和微调流程,提供丰富的社区资源。

3. LangChain

- 简介:专注于大模型应用的框架,支持模型集成和链式任务处理。

- 优势:简化大模型应用的开发流程,提升开发效率。

四、大模型开发技术要点

1. 模型选择与设计

- 预训练模型选择:根据任务需求选择BERT、GPT等预训练模型。

- 模型架构设计:设计网络层数、参数规模和激活函数等。

2. 数据预处理与增强

- 数据清洗:去除噪声数据,提升数据质量。

- 数据标注:为数据添加标签,支持监督学习。

- 数据增强:通过旋转、裁剪、添加噪声等方式扩充数据集。

3. 训练策略与评估指标

- 训练策略:选择优化器(如Adam)、学习率和批次大小等超参数。

- 评估指标:使用准确率、精确率、召回率等指标评估模型性能。

4. 模型压缩与部署

- 模型压缩:通过量化、剪枝等技术减小模型体积。

- 模型部署:将模型部署到服务器、移动端或边缘设备。

五、大模型微调基础

1. 什么是微调

- 定义:在预训练模型的基础上,使用特定领域的数据进行进一步训练,以优化模型在特定任务上的性能。

- 核心目标:使模型更好地适应特定领域的需求。

2. 微调的应用场景

- 领域适配:将通用模型适配到医疗、金融等特定领域。

- 任务优化:提升模型在文本分类、情感分析等特定任务上的性能。

3. 微调方法与技术

- LoRA(Low-Rank Adaptation):通过引入低秩矩阵对模型的权重进行微调。

- QLoRA(Quantized LoRA):结合量化技术,减少存储需求。

- 适配器调整(Adapter Tuning):在模型中添加适配器模块,对特定任务进行优化。

- 前缀调整(Prefix Tuning):在输入序列中添加前缀,引导模型生成特定领域的文本。

- 提示调整(Prompt Tuning):通过优化提示词(Prompt)提升模型性能。

六、大模型微调实战

1. 微调实战案例

- 案例1:使用 LoRA 对 ChatGLM 进行微调,提升模型在医疗领域的文本生成能力。

- 案例2:通过 适配器调整 对 BERT 进行微调,优化模型在情感分析任务上的性能。

2. 微调效果评估

- 评估指标:使用困惑度(Perplexity)、准确率等指标评估微调效果。

- 对比实验:对比微调前后模型在特定任务上的性能差异。

七、结语

《从零开始大模型开发与微调》不仅是一本理论书籍,更是一本实战指南。通过本书,您可以系统掌握大模型开发与微调的核心技术,结合提供的PDF书籍和课程同步源码,快速上手大模型开发实战。无论是初学者还是有一定经验的开发者,都能从本书中获益匪浅。

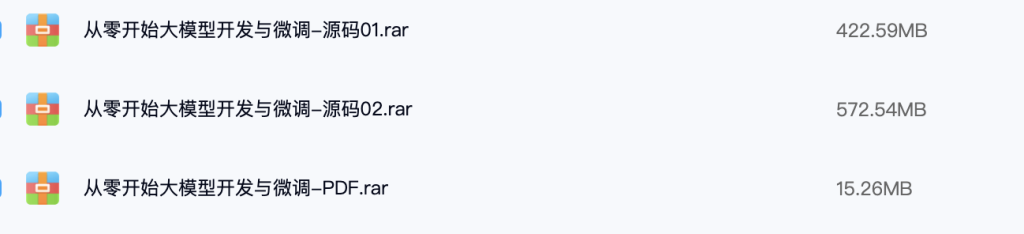

立即下载:

学习建议:

- 先通读书籍,掌握大模型开发与微调的基础理论。

- 结合源码,运行实战案例,加深理解。

- 尝试修改代码,进行自定义开发和微调实验。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

THE END

暂无评论内容